Apple dévoile MGIE, son nouveau modèle LLM

Apple avance à son rythme sur les IA génératives et tout ce qui est intégration IA dans les systèmes et les apps. Même si aujourd’hui, Apple n’a pas son service anti-ChatGPT, ce n’est pas pour autant que la Pomme n’est pas active dans le domaine en mobilisant les budgets R&D et de nombreux ingénieurs.

C’est même tout le contraire. Il ne fait aucun doute qu’en interne les manœuvres sont là et même avant la disponibilité de ChatGPT. Actuellement, le constructeur travaille sur les LLM et annonce régulièrement de nouveaux modèles et des évolutions.

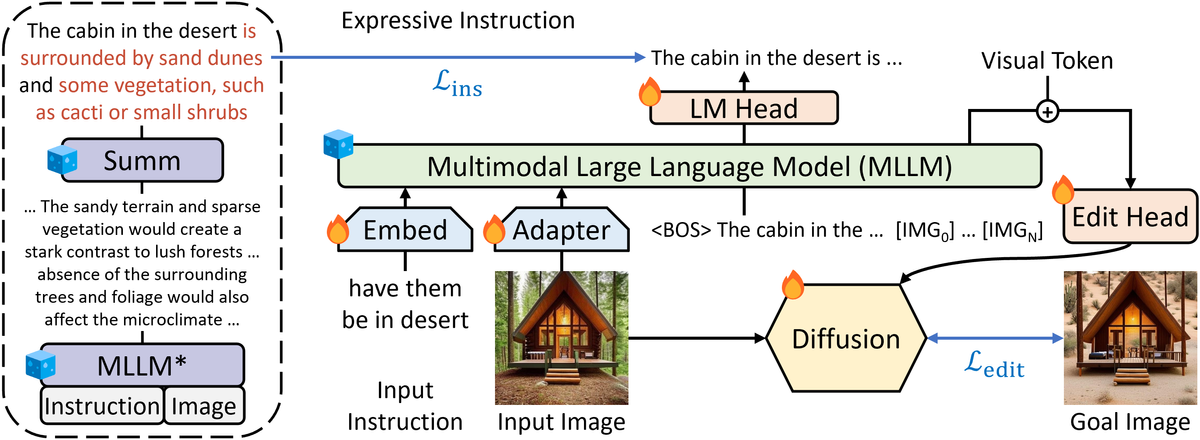

Le dernier LLM est MGIE. Il s’agit d’un Guiding Instruction based image Editing en utilisant un MLLM, c’est à dire un LLM multimodal pour améliorer les performances et surtout la pertinence des actions / réponses.

MGIE est un modèle qui doit aider à modifier une image. Le but est de modifier, faire des retouches parfois complexes selon les demandes du prompt. Les exemples donnés vont très loin dans les modifications. L’intérêt du multimodal est de pouvoir agir sur x éléments et utiliser x fonctions comme le recadrage, la luminosité, modifier l’arrière-plan, etc. Ce sont des actions parfois complexes.

Parallèlement, ce modèle doit être capable de préciser ou mieux comprendre la demande de l’utilisateur ce qui exige une compréhension encore plus élevée.

MGIE complète les usages de Ferret, un LLM pour identifier les éléments d’une image.

Tous ces indices convergent vers une intégration sans doute profonde dans les différents OS et les apps du constructeur. La WWDC, la conférence développeur annuelle de juin, pourrait être le lieu de nombreuses annonces.

Peut-être l'occasion de faire un saut quantique à Siri qui a besoin d'une sérieuse évolution.

Site : https://github.com/apple/ml-mgie